Where To Look: Focus Regions for Visual Question Answering (CVPR2016)を読んだ

Kevin J. Shih, Saurabh Singh, Derek Hoiem, “Where To Look: Focus Regions for Visual Question Answering”, in CVPR2016 link

Summry

を読んだので、軽くメモ。

VQA(Visual Question Answer) 画像に対する質問に対して応答するタスクに対し、その質問クエリに対して画像のどの領域に注目すべきかのモデルの学習方法について論じた論文。

Contribution

- VQA datasetに対して、提案手法を適用。従来手法を全て上回った。

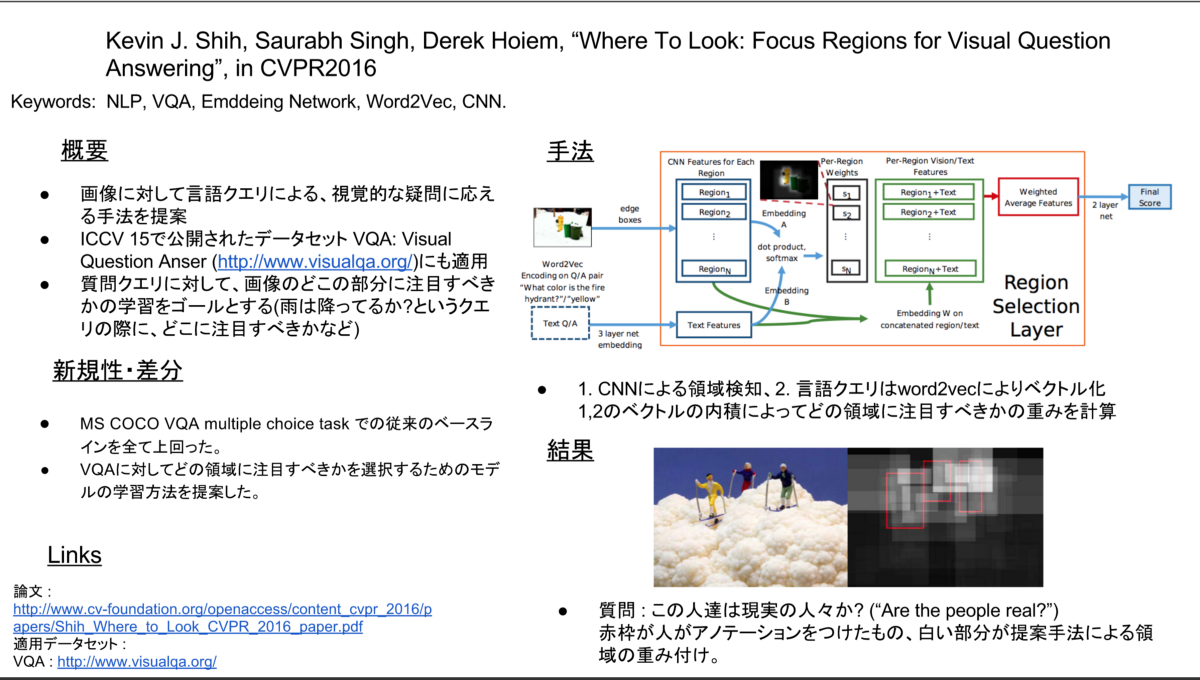

- 画像に対して CNN を用いて物体領域の検出を行った後にベクトル化、質問クエリは

word2vecを用いてベクトル化を行う。 - その 2 つのベクトルを用いて内積計算により重み付けを行うことで、どの領域に注目すべきかを計算する。

Comments

引用文献の訳 9 割が 2014–2015(直近 2 年間)で発表された論文で、改めてこの分野の最先端を駆け抜けるのは凄まじい能力が必要になるなと思いました。

そして相変わらず CVPR の論文のネーミングセンスは良いですね。(ジャケ買いならぬジャケ読み)

単純な質問なら、人間でも瞬間的に解答可能な物が多いなと感じた。

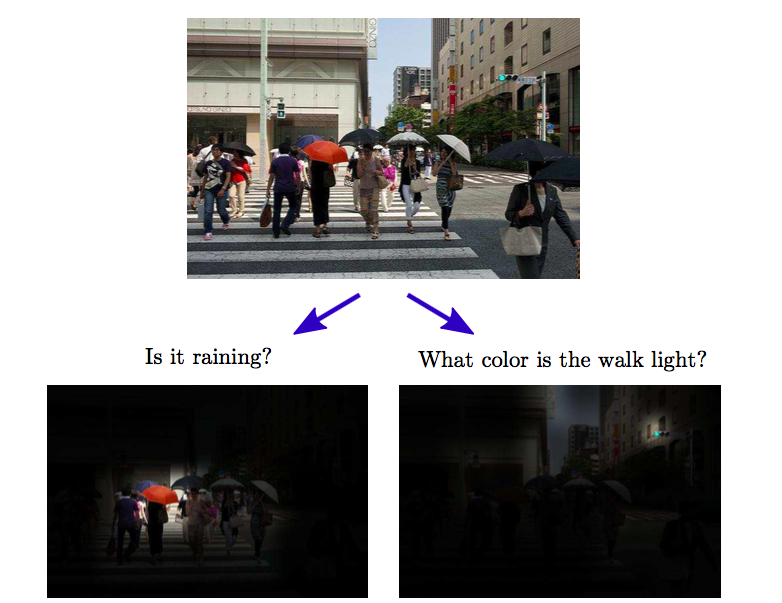

fig. 1

セマンティックな疑問(Fig.1 雨は降っていますか?)の場合、人間に注目した場合は傘をさしているから雨と判断しても良いがもっと広い範囲で画像を見てみると空は快晴なので人間に注目するのは筋が悪く VQA はとても難しくチャレンジングな問題だと書かれていた。(それでも充分すごい領域に到達しているなと思うが)

関連しているかもしれない記事

- Data-driven Crowd Analysis in Videos (ICCV2011)を読んだ

- Slicing Convolutional Neural Network for Crowd Video Understanding (CVPR2016)を読んだ

- Analyzing Free-standing Conversational Groups: A Multimodal Approach (ACMMM15) を読んだ

- Call center stress recognition with person-specific models を読んだ

- FUSE: Full Spectral Clustering(KDD2016) を読んだ

📮 📧 🐏: 記事への感想のおたよりをおまちしてます。 お気軽にお送りください。 メールアドレス入力があればメールで返信させていただきます。 もちろんお返事を希望せずに単なる感想だけでも大歓迎です。

このサイトの更新情報をRSSで配信しています。 お好きなフィードリーダーで購読してみてください。

このウェブサイトの運営や著者の活動を支援していただける方を募集しています。 もしよろしければ、Buy Me a Coffee からサポート(投げ銭)していただけると、著者の活動のモチベーションに繋がります✨

Amazonでほしいものリストも公開しているので、こちらからもサポートしていただけると励みになります。