Dataflow template を使って Google Cloud Pub/Sub の中身を簡単に確認する

PubSub に出力された結果を確認するのって、なかなか手間がかかりませんか?

最近同僚に簡単な確認方法を教えてもらい、感動したのでそれを記事にしました。

確認方法

- PubSub のメッセージを出力する Google Cloud Storage bucket を同一 GCP プロジェクトで作成する。

- GCP の Pub/Sub ページに移動する

- 確認したい Pub/Sub topic をクリックする

- ページ下部にある

CREATE SUBSCRIPTIONボタンを押すと選択肢で、Create subscription,Export to BigQuery,Export to Cloud Storageがあり、Export to Cloud Storageを選択する。- BigQuery、 Google Cloud Storage への吐き出しを行い際に、自動的に subscription が生成される。

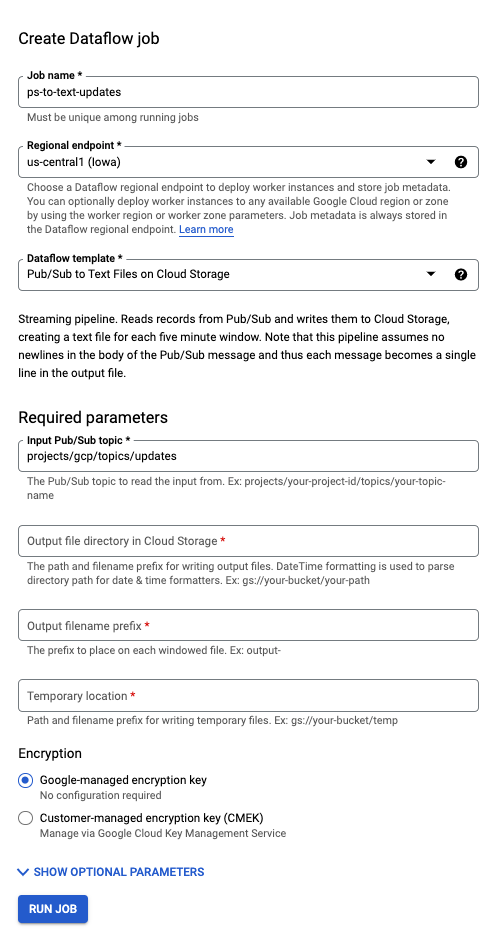

Export to Cloud Storageを選択すると、Text 形式か Abro 形式での出力にするかを選択できる。基本的には簡単に確認できる Text 形式を選ぶと良さげ。- 選択後、下記のような設定画面が出てくるので情報を埋めていく。基本的には、どこの Google Cloud Storage に出力するかを埋めれば完了。

- 10m ほどすると Streaming job の Dataflow の起動が完了して、一定期間ごとに Pub/Sub の topic に公開されたデータがテキスト形式で出力され始めます。

- 出力された GCS の結果を眺めるには、

gsutilコマンドなどを使うのが簡単です。自分はgsutil catの結果をコピーして VS Code で確認しています。

Cloud Dataflow のテンプレート機能については、端的に説明すると、GUI でパラメータを設定するだけで、Dataflow によるデータ処理が簡単に実行できるようになる機能です。

詳しくは、 GCPUG でのCloud Dataflow がテンプレートにより気軽に使えるサーバーレスのサービスに進化した話の記事がわかりやすいのでごらんください。

関連しているかもしれない記事

- gcloud commands で Pub/Sub に jsonファイルをメッセージとして公開 (Pusblish) する

- CloudComposer のDAGをCircleCIで更新する

- GCPのCloud Composer のDAGを素早く・簡単にデバッグする

- GKE 上にて Pythonで logger.info() を行うとCloud logging では stderr に保存され、すべてエラーになる問題への対処法

- 遅すぎる `pandas.read_gbq` を使わずに、Google BigQueryから高速にデータを読み込む

📮 📧 🐏: 記事への感想のおたよりをおまちしてます。 お気軽にお送りください。 メールアドレス入力があればメールで返信させていただきます。 もちろんお返事を希望せずに単なる感想だけでも大歓迎です。

このサイトの更新情報をRSSで配信しています。 お好きなフィードリーダーで購読してみてください。

このウェブサイトの運営や著者の活動を支援していただける方を募集しています。 もしよろしければ、Buy Me a Coffee からサポート(投げ銭)していただけると、著者の活動のモチベーションに繋がります✨

Amazonでほしいものリストも公開しているので、こちらからもサポートしていただけると励みになります。